GPT 5.2 Codex i Microsoft Foundry: sikker kode‑AI for store refaktoreringer og sårbarhetsanalyse

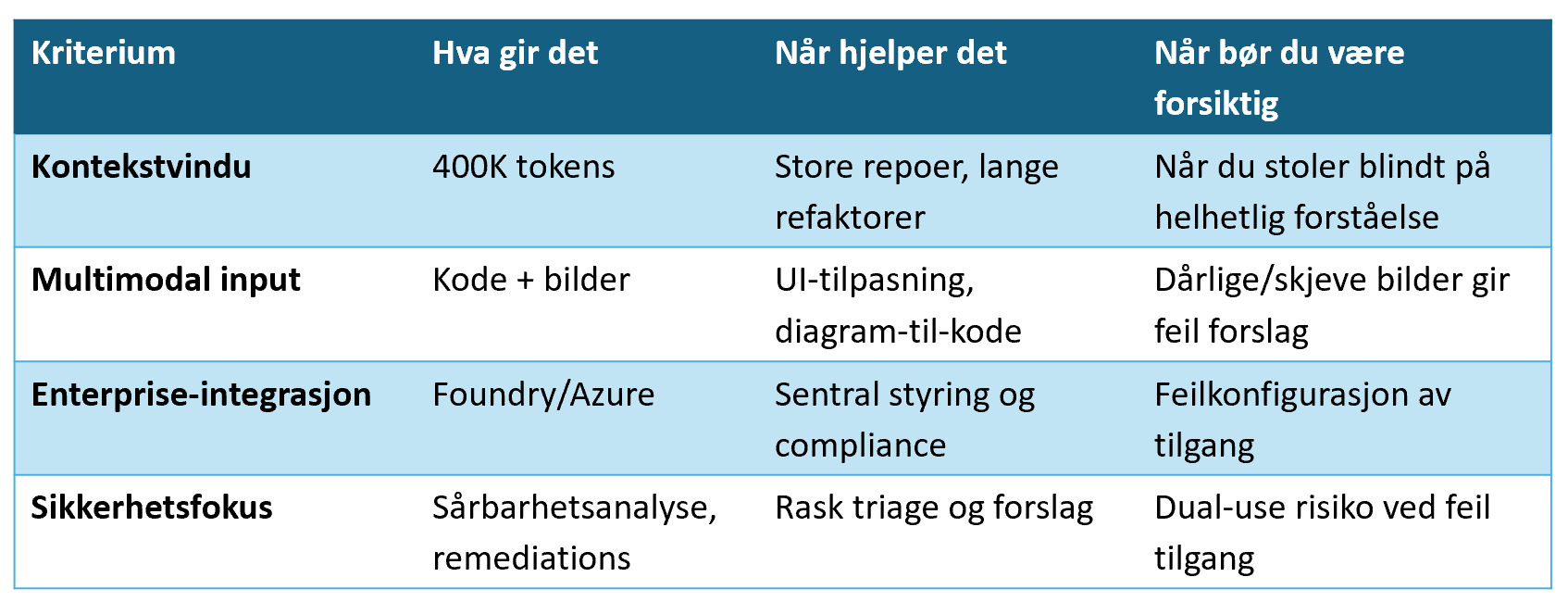

GPT 5.2 Codex er nå tilgjengelig i Microsoft Foundry. Kort sagt betyr det at en kraftig kodefokusert språkmodell nå kan brukes innenfor en plattform som er laget for bedrifter, med ekstra fokus på sikkerhet og styring. For utviklere kan dette gi raskere refaktorering, bedre kodeforslag og hjelp til sårbarhetsanalyse. For organisasjonen betyr det at du må tenke gjennom governance, testing og tilgangskontroll før du slipper modellen løs på produksjonskode. OpenAI beskriver også forbedret agentisk kodeevne og sterkere cybersikkerhetskapasiteter i denne versjonen.

Hva er nytt og hvorfor betyr det noe?

Modellen er laget for å håndtere lange sammenhenger. Den kan jobbe med store kodebaser og følge tråden i komplekse endringer over tid. Den kan også ta inn flere typer input, for eksempel kode og bilder, noe som gjør den nyttig når du skal oversette design til implementasjon eller forstå skjermbilder og diagrammer i sammenheng med kode.

At modellen leveres gjennom Microsoft Foundry og Azure betyr at den kan kobles inn i eksisterende verktøy for logging, tilgangsstyring og samsvar. Det gjør det enklere å rulle ut i en organisasjon som allerede bruker Azure, men det betyr ikke at alt blir trygt av seg selv. Du må fortsatt sette opp riktige policyer og tekniske kontroller.

Hva hjelper dette med i praksis?

Modellen kan være nyttig i flere konkrete arbeidsflyter:

Refaktorering av store kodebaser: Den kan holde oversikt over sammenhengen i mange filer og foreslå endringer som tar hensyn til helheten

Kodegjennomgang og forslag til forbedringer: Den kan peke på potensielle feil og foreslå mer idiomatisk kode

Sårbarhetsanalyse og forslag til fikser: Den kan hjelpe med å identifisere mønstre som ofte fører til sikkerhetsproblemer og foreslå remediations

Dokumentasjon og forklaringer: Den kan generere forklarende tekst til komplekse funksjoner, eller hjelpe nye utviklere å forstå eldre kode

Alt dette kan spare tid, men det krever at du har gode rutiner for validering. Modellens forslag må testes og gjennomgås, akkurat som kode skrevet av mennesker.

Hva betyr det i praksis?

Risikoer og hvordan håndterer du dem?

Det finnes noen klare fallgruver som du må ta høyde for:

Modellhallusinasjoner: Modellen kan finne på kode som ser plausibel ut, men som er feil eller usikker. Løsning: alltid kjør statisk analyse, enhetstester og integrasjonstester på modellgenerert kode.

Lekkasjer av sensitiv informasjon: Hvis du sender konfidensiell kode eller hemmelige nøkler i prompts, kan det bli eksponert. Løsning: maskér sensitiv data, og begrens hvilke repoer som kan brukes i prompts.

Feilkonfigurasjon av tilgang: Hvis for mange får tilgang til modellens kraftige funksjoner, øker risikoen for misbruk. Løsning: bruk streng rollebasert tilgangskontroll og logging av alle forespørsler.

Varierende kvalitet mellom språk og rammeverk: Modellen er god på mange språk, men ikke likt god på alle. Løsning: test kvaliteten i de språkene og rammeverkene dere faktisk bruker.

Kort sagt, modellen er et verktøy som kan gjøre mye, men den erstatter ikke gode prosesser.

Praktisk plan for pilot og utrulling

Her er en konkret plan du kan følge for å komme i gang uten å ta unødvendig risiko:

Velg pilotrepoer: Ta to representative repoer, en med eldre kode og en med nyere arkitektur. Kjennskap til disse repoene gjør det enklere å måle effekt.

Sett opp en sandkasse: Kjør modellen i et isolert miljø uten tilgang til produksjonsdata. Dette gir rom for eksperimentering uten risiko.

Automatiser validering: Alle forslag fra modellen må gå gjennom statisk analyse, dependency scanning og enhetstestrunder i CI pipeline før de kan merges.

Definer governance: Lag klare regler for hva som kan sendes i prompts, hvem som kan bruke modellen, og hvordan logging og revisjon skal fungere.

Tren laget: Gi utviklere opplæring i hvordan de skriver gode prompts, hvordan de vurderer modellens forslag, og hvilke begrensninger de må være oppmerksomme på.

Mål effekten: Sett KPIer for tid spart, feilrate, og antall sikkerhetshendelser knyttet til modellbruk. Følg disse over tid og juster policyer etter behov.

Praktiske tips for daglig bruk

Behold menneskelig godkjenning: Modellens forslag kan være nyttige, men la alltid en utvikler godkjenne endringer som går til produksjon

Bruk små, repeterbare prompts: Del opp store oppgaver i mindre steg for å få mer presise forslag

Maskér eller anonymiser sensitiv informasjon før du sender den til modellen

Logg alt: Ha full sporbarhet på hvem som spurte hva, og hvilke svar modellen ga

Start konservativt: Gi modellen tilgang til ikke kritiske deler av koden først, og utvid etter hvert som dere får erfaring

Ofte stilte spørsmål

Hva er GPT 5.2 Codex i Microsoft Foundry?

GPT 5.2 Codex er en kodefokusert stor språkmodell tilgjengelig gjennom Microsoft Foundry som er designet for enterprise bruk med funksjoner for lange kontekster, multimodal input og integrasjon med Azure‑økosystemet.

Hvilke typer oppgaver egner modellen seg best for?

Modellen er spesielt nyttig for store refaktoreringer, kodegjennomganger, automatisert dokumentasjon, sårbarhetsanalyse og oppgaver som krever forståelse av sammenheng over mange filer eller lange samtaler.

Hvor stor er kontekstvinduet?

Modellen støtter et svært langt kontekstvindu som gjør at den kan resonnere over store kodebaser og lange arbeidsflyter. Dette gjør den bedre egnet for oppgaver som krever helhetlig forståelse.

Hva betyr multimodal input i praksis?

Multimodal input betyr at modellen kan ta inn flere typer data samtidig, for eksempel kildekode og bilder som skjermbilder eller diagrammer, for å gi mer kontekstuelle og relevante forslag.

Hvordan integreres modellen i eksisterende utviklingsverktøy?

GPT 5.2 Codex leveres via Microsoft Foundry og kan kobles til CI/CD‑pipelines, kodeverktøy og governance‑rammeverk i Azure for sentralisert styring, logging og tilgangskontroll.

Hvilke sikkerhetsmekanismer følger med?

Foundry tilbyr verktøy for tilgangskontroll, logging og revisjon. Organisasjoner må i tillegg implementere RBAC, data‑maskering og policyer for å hindre lekkasje av sensitiv informasjon.

Kan modellen brukes på private repoer?

Ja, men det krever korrekt konfigurasjon av tilgang og governance. Sensitive repoer bør først testes i isolerte sandkasser og prompts må renses for hemmeligheter.

Hva er de viktigste risikoene ved bruk?

De viktigste risikoene er modellhallusinasjoner som genererer feil kode, lekkasje av sensitiv informasjon via prompts, og feilkonfigurasjon av tilgang som kan gi uautorisert bruk.

Hvordan kan vi redusere risikoene?

Bruk sandkasse for piloter, maskér sensitiv data, håndhev streng RBAC, logg alle forespørsler, og krev menneskelig godkjenning og automatisert testing før produksjonsdeploy.

Hvordan bør modellgenerert kode valideres?

Alle forslag bør gå gjennom statisk analyse, dependency scanning, enhetstester og integrasjonstester i CI‑pipeline før de merges til hovedgrenen.

Støtter modellen alle programmeringsspråk?

Modellen støtter mange språk og rammeverk, men kvaliteten kan variere. Test modellens ytelse i de språkene og rammeverkene dere faktisk bruker.

Hva med personvern og samsvar?

Samsvar avhenger av hvordan Foundry og Azure er konfigurert i din organisasjon. Kartlegg regulatoriske krav tidlig, og bruk logging og revisjon for etterprøvbarhet.

Hvordan starte en pilot?

Velg representative repoer, sett opp en isolert sandkasse, definer KPIer for feilrate og tid spart, automatiser validering i CI og lag klare governance‑regler før utvidelse.

Hva koster det å bruke GPT 5.2 Codex i Foundry?

Kostnader avhenger av lisensmodell, forbruk og Azure‑konfigurasjon. Kontakt Microsoft eller din Azure‑leverandør for nøyaktig prisinformasjon og kostnadsmodell.

Hvem bør involveres i utrullingen?

Involver utviklingsteam, sikkerhetsteam, DevOps, compliance og ledelse for å sikre at tekniske, juridiske og operasjonelle krav blir ivaretatt.

Hvor finner vi dokumentasjon og støtte?

Dokumentasjon og støtte leveres gjennom Microsoft Foundry og Azure‑kanaler. Bruk offisiell dokumentasjon for integrasjon, sikkerhet og beste praksis.

Kan modellen erstatte utviklere?

Nei. Modellen er et verktøy som kan øke produktiviteten og hjelpe med repetitive eller komplekse oppgaver, men menneskelig vurdering og godkjenning er fortsatt nødvendig.

Hvordan måler vi suksess med modellen?

Sett KPIer som tid spart per oppgave, antall feil i produksjon, antall sikkerhetshendelser knyttet til modellbruk og utviklertilfredshet. Følg disse over tid og juster policyer etter behov.

Trenger du hjelp?

Dette er et verktøy som kan gi reell gevinst for team som jobber med store og komplekse kodebaser. Men gevinstene kommer ikke av seg selv. Invester i sandkasse, automatisert testing, klare policyer og opplæring før du gir modellen tilgang til kritiske systemer. Vil du ha hjelp til å lage en pilotplan, testscenarier eller en sjekkliste for CI validering, så kan jeg sette det opp for deg.

Les også

- GPT 5.1 codex max i Microsoft Foundry: Hvordan bruke AI for repo skala refaktorering, CI automatisering og sikkerhet

- GPT 5.1 i Azure AI Foundry: praktisk guide for utviklere, kostnad og pilot

- Slik bygger du AI-agenter med Azure AI Foundry – fra prototype til produksjon med CI/CD og sikkerhet

- Topp 5 beste praksiser for agentobservabilitet i Azure AI Foundry – sikre pålitelig generativ AI

- Hvordan forbedrer GPT-5 Dynamics 365 for kundeservice, automatisering og datadrevet innsikt

- Hvordan red teaming med Azure AI Evaluation SDK gjør RAG-apper mer presise og robuste?

- Erfaringer med GPT-5 i Microsoft Copilot – AI-ingeniørens guide til smartere arbeidsflyt og produktivitet

- GPT-5 i Azure AI Foundry – ansvarlig AI i produksjon

- Revolusjonér norsk helse med Foundation Models & RAG

- Bygg din første stemmeagent med Voice Live API | Microsoft Azure-guide

- Språkteknologi i Norge 2025: Slik inkluderer AI alle språk og kulturer

- Model Context Protocol (MCP): Teknologisk fremskritt med sikkerhetsutfordringer

- Agentisk AI: Autonome digitale kollegaer som former fremtidens arbeidsliv

- Slik gir AI norske bedrifter konkurransefortrinn

- Llama 4 møter påskefjellet: Kunstig intelligens med norsk vri 2025

- EU-lovgivning gir AI-regulering turbo: Slik påvirkes robotene våre

- AI-revolusjonen med Azure AI Foundry: Fra kaos til kontroll for småbedrifter

- AI-sikkerhetsagenter med Security Copilot: Gjør cybersikkerhet engasjerende

- Veikart til suksess med Copilot: Slik lykkes mellomstore bedrifter med AI

- Fremtiden for koding med KI-kodeassistenter: Microsoft Copilot i praksis

- Copilot og Azure AI: Automatiser og effektiviser arbeidet