Hvordan red teaming med Azure AI Evaluation SDK gjør RAG-apper mer presise og robuste?

I en tid der generative AI-løsninger som Retrieval-Augmented Generation (RAG) raskt tas i bruk, er det avgjørende å sikre at appene er robuste, nøyaktige og fri for hallusinasjoner. Ved hjelp av red teaming med Azure AI Evaluation SDK kan du identifisere svakheter, forbedre grounding og sikre høy kvalitet i svarene dine. Her får du en forbedret, konkret metode som kombinerer strukturert testing, automatiserte vurderinger og kontinuerlig oppfølging.

Hvorfor er red teaming av RAG-apper med Azure AI Evaluation SDK kritisk for robusthet

En tradisjonell funksjonstest sjekker at alt virker under ideelle forhold. Red teaming tar dette et steg videre ved å simulere fiendtlige scenarioer:

Spørsmål som utfordrer nøyaktigheten og påliteligheten

Motstridende formuleringer som tester gjenfinning og generering

Bevisste forsøk på å utløse hallusinasjoner uten underlag i dokumentasjonen

Et anaonymisert eksempel: Etter en uavhengig gjennomgang oppdaget de 15 uventede hallusinasjoner, noe som førte til en 20 % forbedring i grounding etter at de justerte søkekonfigurasjonen.

Slik bygger du et solid sett med ground-truth Q/A-par for RAG-evaluering

Kvaliteten på referansedata styrer nøyaktigheten i vurderingene:

Samle domenespesifikk dokumentasjon.

Generer minst 200 spørsmål-svar-par med kode:

from azure.ai.generative.evaluation import QADataGenerator generator = QADataGenerator() ground_truth = generator.generate( text=full_document_text, qa_type="extractive", num_questions=200 )Gjennomfør manuell validering:

La eksperter sikre dekning av edge-cases og korrekt terminologi

«Takk for engasjementet», sier utviklerne som oppdaget både syntaksfeil og misvisende begrepsbruk

Les mer: Local Evaluation med Azure AI Evaluation SDK

Automatisert QA-evaluering av RAG-apper med Azure AI Evaluation SDK

Med pålitelige referansedata kan du sette opp repeterbare tester uten manuelt arbeid:

from azure.ai.generative.evaluation import Evaluators

results = Evaluators.batch_evaluate(

target=chat_function,

data=ground_truth,

data_mapping={"prompt": "question", "expected_response": "answer"},

metrics_list=["accuracy", "grounding", "completeness"],

llm_params={"temperature": 0.2, "top_k": 5} )

Les av gjennomsnittsscore for hver metrikk (1–5).

Beregn pass-rate: andelen svar med score ≥ 4 bør ideelt ligge over 85 %.

Spor trender over tid og sammenlign med tidligere kjøringer for å avdekke regresjoner.

Les mer: RAG-evaluators for generative AI

Adversarielle tester for robusthet og hallusinasjonskontroll i generative AI

For å sikre at modellen tåler tøffe vilkår, kan du:

Lage spørsmål basert på bevisst feilaktige påstander fra dokumentene

Formulere samme spørsmål med ulike synonymer og strukturer

Inkludere sjeldne begreper for å teste om retrieveren finner riktig innhold

Ved å sammenligne scoren på normale spørsmål med score på fiendtlige case får du en klar indikasjon på modellens robusthet.

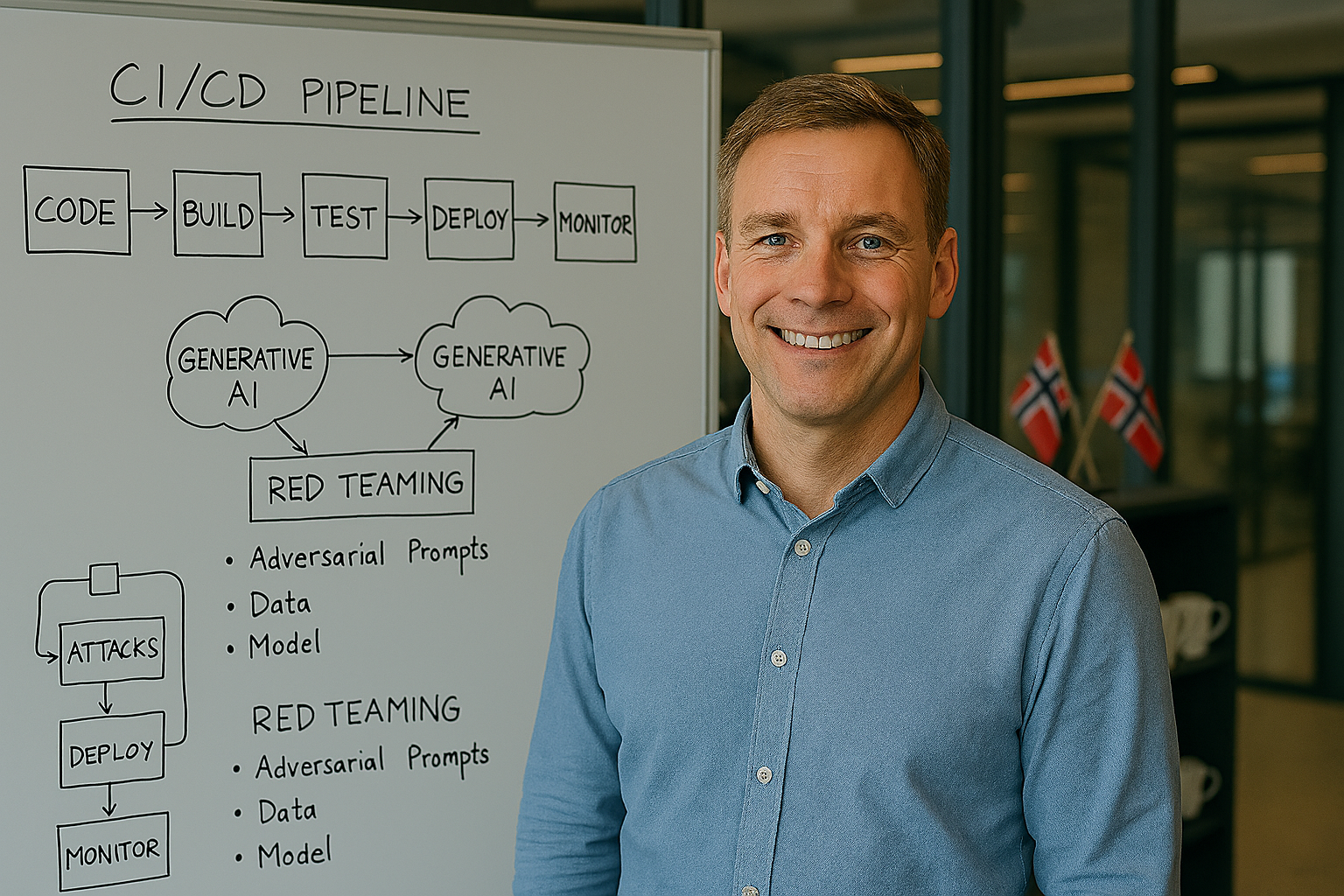

CI/CD-testing av RAG-apper med Azure AI Evaluation SDK

Automatiser gjennomført testing ved hver endring:

jobs:

red_team_assessment:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v2

- name: Sett opp Python

uses: actions/setup-python@v2

with:

python-version: 3.9

- name: Installer avhengigheter

run: pip install azure-ai-generative

- name: Kjør red teaming-test

run: python tests/run_red_team.py

- name: Sammenlign resultater run: python tests/analyze_results.py --

threshold 0.85

Pipelinen kjører:

Når systemmeldinger eller prompts endres

Ved justering av LLM-parametere (temperatur, maks tokens)

Ved oppdateringer i retriever-strategien

Automatiser varsling dersom pass-rate faller under 85 % eller hvis gjennomsnittsscoren synker.

Tolkning av resultater og kontinuerlig forbedring RAG-appen

Scorefordeling: En høy andel 5-ere indikerer overlegen nøyaktighet, mens mange 3-ere kan tyde på behov for bedre dokumentunderlag

Pass-rate under 85 %: Identifiser hvilke spørsmål som feilet, og se om det skyldes hallusinasjoner, søkestrategi eller LLM-parametere

Kontinuerlig forbedring: Juster temperatur, top k eller retriever-modell, og kjør en ny vurderingsrunde

Ved å implementere red teaming med Azure AI Evaluation SDK får du en skalerbar metode for å forbedre generative AI-løsninger.

Ofte stilte spørsmål

Hvordan skiller red teaming seg fra vanlig testing?

Red teaming simulerer fiendtlige scenarioer og utfordrer modellen med vanskelige, misvisende eller uvanlige spørsmål – i motsetning til tradisjonell testing som fokuserer på ideelle forhold.

Hvor mange spørsmål-svar-par trenger jeg for en god evaluering?

Minimum 200 par anbefales for å dekke bredden i domenet og sikre statistisk gyldige resultater.

Hva er en god pass-rate for RAG-evaluering?

En pass-rate over 85 % (score ≥ 4) anses som robust. Lavere score kan indikere behov for justeringer i retriever, dokumentasjon eller LLM-parametere.

Kan jeg automatisere red teaming i CI/CD?

Ja, Azure AI Evaluation SDK støtter automatisert testing ved hver endring i pipeline, slik at du kontinuerlig kan overvåke kvalitet og robusthet.

Del dine erfaringer med red teaming av RAG-apper

Hva har vært dine største utfordringer med red teaming av RAG-apper? Hvilke edge-cases har overrasket deg? Del gjerne dine erfaringer med oss. Sammen kan vi lære av hverandre og bygge en inkluderende og robust bestepraksis for AI-drevne chatløsninger.

Les også:

- GPT 5.2 Codex i Microsoft Foundry: sikker kode AI for store refaktoreringer og sårbarhetsanalyse

- GPT 5.1 codex max i Microsoft Foundry: Hvordan bruke AI for repo skala refaktorering, CI automatisering og sikkerhet

- GPT 5.1 i Azure AI Foundry: praktisk guide for utviklere, kostnad og pilot

- Slik bygger du AI-agenter med Azure AI Foundry – fra prototype til produksjon med CI/CD og sikkerhet

- Topp 5 beste praksiser for agentobservabilitet i Azure AI Foundry – sikre pålitelig generativ AI

- Hvordan forbedrer GPT-5 Dynamics 365 for kundeservice, automatisering og datadrevet innsikt

- Erfaringer med GPT-5 i Microsoft Copilot – AI-ingeniørens guide til smartere arbeidsflyt og produktivitet

- GPT-5 i Azure AI Foundry – ansvarlig AI i produksjon

- Revolusjonér norsk helse med Foundation Models & RAG

- Bygg din første stemmeagent med Voice Live API | Microsoft Azure-guide

- Språkteknologi i Norge 2025: Slik inkluderer AI alle språk og kulturer

- Model Context Protocol (MCP): Teknologisk fremskritt med sikkerhetsutfordringer

- Agentisk AI: Autonome digitale kollegaer som former fremtidens arbeidsliv

- Slik gir AI norske bedrifter konkurransefortrinn

- Llama 4 møter påskefjellet: Kunstig intelligens med norsk vri 2025

- EU-lovgivning gir AI-regulering turbo: Slik påvirkes robotene våre

- AI-revolusjonen med Azure AI Foundry: Fra kaos til kontroll for småbedrifter

- AI-sikkerhetsagenter med Security Copilot: Gjør cybersikkerhet engasjerende

- Veikart til suksess med Copilot: Slik lykkes mellomstore bedrifter med AI

- Fremtiden for koding med KI-kodeassistenter: Microsoft Copilot i praksis

- Copilot og Azure AI: Automatiser og effektiviser arbeidet